Press and Media

Published in Journal of Neurocomputing:

Understanding activation patterns in artificial neural networks by exploring stochastic processes: Discriminating generalization from memorization

Stephan Johann Lehmler, Muhammad Saif-ur-Rehman, Tobias Glasmachers, Ioannis Iossifidis

for more details:

https://doi.org/10.1016/j.neucom.2024.128473

Sebastian Doliwa and Muhammad Ayaz Hussain and Tim Sziburis and Ioannis Iossifidis

Timing plays a vital role in the generation of naturalistic behavior satisfying all constraints arising from interacting with a dynamic environment while adapting the planning and execution of action sequences on-line.

In biological systems, many of the physiological and anatomical functions follow a particular level of periodicity and stabilization. The main aspect thereof is stabilizing movement timing against limited perturbations.

In the current work, we develop a model for timed movement preserving the serial order of actions by maintaining an approximately constant overall movement time which guarantees a temporal stabilized behavior of the system.

Action sequences are generated by dynamical system attractors providing a framework for robust incorporation of fluctuating sensor information. Movement satisfying a specific timing is of rhythmic nature which enables us to model the control of timed motion through stable limit cycles utilizing a Hopf oscillator.

We demonstrate the overall system both in simulation and on a physical robotic system by means of intercepting a moving target in three-dimensional space. For the prediction and correction of the target and current positions, an extended Kalman filter (EKF) is implemented and a modified Hopf oscillator generates the velocity profiles for the robotic arm.

In both videos, it is shown that first the implemented Kalman filter estimates the position of the ball, which then provides the Hopf oscillator with the correct set of parameters to ultimately generate the velocity profile for the robot arm to hit the ball. Limiting factor for the demostration was that only a small amount of joint acceleration was possible at the kuka lwr, resulting in relatively slow arm movements..

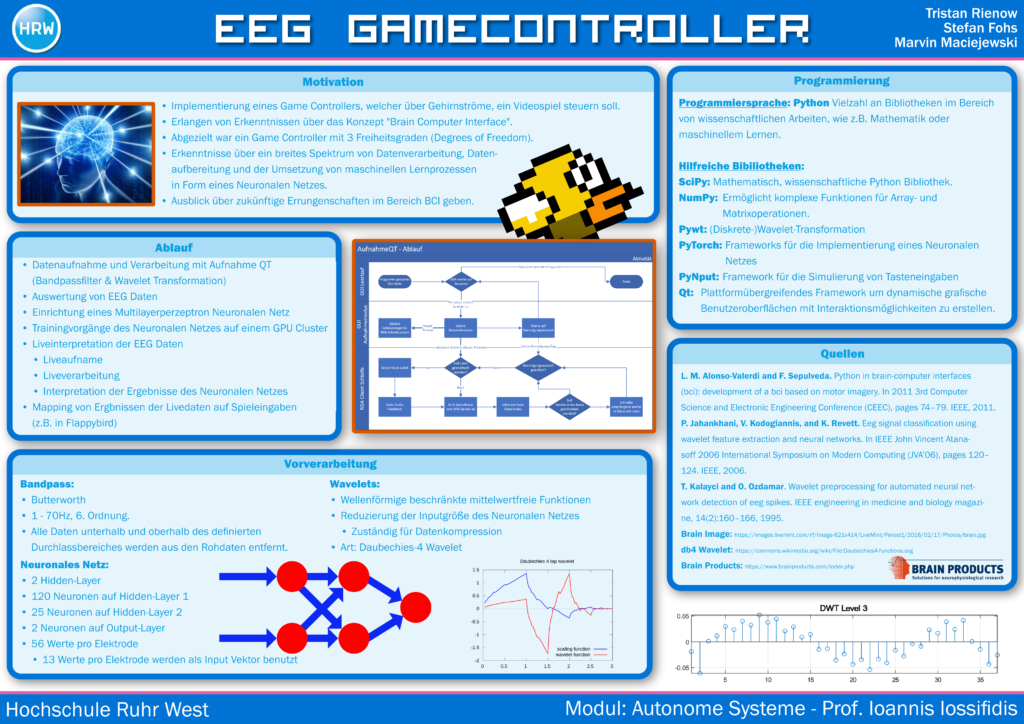

Student project within the module “Autonomous Systems” at Ruhr West University of Applied Sciences.

| Students | Marvin Maciejewski, Stefan Fohs, Tristan Rienow |

| Supervision | Prof. Dr. Ioannis Iossifidis |

| Project site | https://gitlab.hs-ruhrwest.de/iSystemsStudentProjects/2020/eeg-emg-gamecontroller |

live demo

Student project within the module “Autonomous Systems” at Ruhr West University of Applied Sciences.

| Students | Philipp Lösch, Lars Telöken, Ralf Wenzel, Alex Wichmann |

| Supervision | Prof. Dr. Ioannis Iossifidis |

| Project site | https://gitlab.hs-ruhrwest.de/iSystemsStudentProjects/2020/eeg-emg-gamecontroller |

live demo

The robot Baxter ist modeled in Unity3D and a UDP interface is implemented for multi process communication. The UDP interface connects also the real robot with the VR-Robot and can be used to either execute learn motion in the VR on the real robot or just to monitor in the VR the executed movements of the real robot. The simulator includes also an implementation of an analytic solution for the inverse kinematics

In der 2. Episode am 15. April 2021 erklärt Prof. Dr. Ioannis Iossifidis was es mit Exoskeletten, Roboteranzügen und klugen Handschuhen auf sich hat. Mit dem was er macht, hilft er zum Beispiel Parkinson-Patienten, um ihnen neue Chancen zu eröffnen. Ob das Ganze wie in einem Computerspiel funktioniert und wie er seine Forschung ins Studium einbringt, erzählt er in die-sem Podcast.

Read more:

https://www.research-news.org/2021/03/16/hochschule-ruhr-west-startet-podcast-der-wissen-schafft/

Einen „Virtuellen Arm- und Handtest mithilfe von maschinellem Lernen bei neurologischen Bewegungsstörungen“ entwickeln nun Forscher an der Hochschule Ruhr West (HRW) gemeinsam mit Partnern. Das Projekt VAFES wird mit Mitteln des europäischen Fonds für regionale Entwicklung und des Landes Nordrhein-Westfalen gefördert.

Read more:

Wissenschaftler der Hochschule Ruhr West (HRW) und ihre Partner im Forschungsprojekt „VAFES“ entwickeln einen „Virtuellen Arm- und Handtest mithilfe von maschinellem Lernen bei neurologischen Bewegungsstörungen“.

Die Arm- und Handbewegungen von Parkinson- und Schlaganfall-PatientInnen mit Rückenmarksverletzungen sind oft stark eingeschränkt. Diese Einschränkungen haben enorme Auswirkungen auf die Lebensqualität der betroffenen PatientInnen. Eine differenzierte Diagnose der Hand- und Armfunktion ist sowohl zur Therapiesteuerung als auch zur Früherkennung von großer Bedeutung.

Read more:

https://biermann-medizin.de/expertenteam-entwickelt-diagnosesystem-fuer-parkinson-patienten/

Interview mit Prof. Ioannis Iossifidis, Head of Robotics and BCI Laboratory, Hochschule Ruhr West

25.02.2020

Häufig werden neurologische Erkrankungen, wie zum Beispiel Parkinson, erst spät diagnostiziert. Um den Menschen eine frühere Diagnose zu ermöglichen, wurde das Projekt VAFES ins Leben gerufen. Mithilfe von Sensorik und VR soll ein spielerisches Testsystem entwickelt werden.

Prof. Ioannis Iossifidis, Head of Robotics and BCI Laboratory, Hochschule Ruhr West

Im Gespräch mit MEDICA.de berichtet Professor Iossifidis, wie das Projekt zustande kam, welche Schritte geplant sind und was die Zielsetzung ist.

Herr Prof. Iossifidis, was war der Hintergrund, der das Projekt VAFES ins Rollen gebracht?Prof. Ioannis Iossifidis: Bei diesem Projekt geht es um Patienten, die eine Armdysfunktion als Folge einer neurologischen Erkrankung zeigen, der Fokus liegt insbesondere auf Parkinson-Patienten. Hier ist das Ziel ein verlässliches Diagnosesystem zu entwickeln. Damit soll die Einordnung der Indikatoren für die Diagnose möglich werden. Diese zu bestimmen, sowie den Verlauf möglicher Therapien automatisiert nachhalten und bewerten zu können, ist das Ziel.

Es gibt bereits einen Armtest, den sogenannten Action Research Arm Test (ARAT), der im Prinzip aus einem Koffer und einigen Holzteilen, Unterlegscheiben und dergleichen besteht. Damit führen die Patienten, die ein gewisse Dysfunktionen im Griff oder in der Armbewegung haben, Übungen aus und werden dabei von einem Arzt beobachtet. Auf der Basis dieses Tests wird dann vom Arzt eine Kategorisierung durchgeführt. Diese Methode ist jedoch nicht besonders genau und sehr subjektiv, was sich auch in den Beurteilungen wiederfindet.

Read more:

http://www.uk.rub.de/aktuell/bmh/meldung00903.html.de

Wirtschafts- und Digitalminister Prof. Dr. Andreas Pinkwart (rechts) überreicht den Förderbescheid. V.l.: Prof. Dr. Ioannis Iossifidis (Hochschule Ruhr West, Bottrop), Dr. Christian Klaes (Universitätsklinikum Knappschaftskrankenhaus Bochum), Dr. Corinna Weber (SNAP GmbH, Bochum), Dr. Matthias Sczesny-Kaiser (BG Universitätsklinikum Bergmannsheil, Bochum) © MWIDE NRW / M.Hermenau

Mit einem neuen Testsystem wollen Forscher neurologische Bewegungsstörungen künftig schneller und sicherer diagnostizieren. Das Testsystem soll in der virtuellen Realität umgesetzt werden und intelligente Konzepte des maschinellen Lernens integrieren.

Für ihr Projekt VAFES (Virtueller Arm- und Handtest mit Hilfe von maschinellem Lernen bei neurologischen Bewegungsstörungen) erhält das Team in den nächsten drei Jahren eine Förderung von rund 2,4 Mio. Euro. Prof. Dr. Andreas Pinkwart, Minister für Wirtschaft und Digitalisierung des Landes NRW, übergab kürzlich den Förderbescheid.

Maschinelles Lernen für die Parkinson-Diagnostik nutzbar machen

Patienten mit neurologischen Erkrankungen oder Verletzungen leiden häufig unter einer stark eingeschränkten Funktion von Händen und Armen. Das betrifft beispielsweise Patienten mit einem Parkinson-Syndrom, aber auch Schlaganfall- oder rückenmarkverletzte Patienten. Die frühzeitige und zuverlässige Erkennung solcher Fehlfunktionen ist oft anspruchsvoll, und die etablierten Diagnostikverfahren sind mitunter nicht ausreichend.

Ein neues Testsystem soll Abhilfe schaffen. Dazu wollen die Forscher des Projektes VAFES einen Sensorhandschuh entwickeln, mit dem Patienten in einer virtuellen Realität standardisierte Bewegungsaufgaben lösen sollen. Die Bewegungsmuster, die dabei aufgenommen werden, werden mit Konzepten des maschinellen Lernens ausgewertet. Zusätzlich werden noch weitere Biosignale des Patienten in die Auswertung integriert. So wollen die Forscher künftig ein selbstlernendes System entwickeln, das eine zuverlässige Diagnose, Klassifikation und Therapiesteuerung von neurologisch bedingten Minderfunktionen von Händen und Armen bereitstellen kann.

Therapeutisch werden die gewonnen Erkenntnisse zur Behandlung von Muskelzittern (Tremor), zur Etablierung VR-gestützter Neurofeedback-Therapieansätze extrapyramidaler und zerebellärer Bewegungsstörungen und zur Feinkalibrierung der Tiefenhirnstimulation bei der Parkinsonbehandlung eingesetzt. Die entwickelten modularen Hard- und Software-Komponenten werden sowohl klinisch/wissenschaftlich (VR-Testumgebung) als auch wirtschaftlich (Testinstrument, Decoder, aktiver Sensorhandschuh) verwertet.

Projektpartner aus Wissenschaft, Klinik und Industrie

Das Institut Informatik der Hochschule Ruhr West übernimmt mit Prof. Dr. Ioannis Iossifidis die Rolle des Konsortialführers. Projektpartner sind das BG Universitätsklinikum Bergmannsheil Bochum, vertreten durch Dr. Matthias Sczesny-Kaiser von der Neurologischen Klinik, das Universitätsklinikum Knappschaftskrankenhaus Bochum, vertreten durch Dr. Christian Klaes, und die SNAP GmbH, vertreten durch Dr. Corinna Weber. Für ihr Vorhaben erhalten die Projektpartner für die nächsten drei Jahre eine Förderung aus Mitteln des europäischen Fonds für regionale Entwicklung (EFRE) und des Landes Nordrhein-Westfalen in Höhe von 2,36 Millionen Euro.

Über das Bergmannsheil

Das BG Universitätsklinikum Bergmannsheil zählt zu den größten Akutkliniken der Maximalversorgung im Ruhrgebiet. 1890 als erste Unfallklinik der Welt zur Versorgung verunglückter Bergleute begründet, vereint das Bergmannsheil heute 23 hochspezialisierte Kliniken und Fachabteilungen unter einem Dach. Rund 2.200 Mitarbeiter stellen die qualifizierte Versorgung von rund 84.000 Patienten pro Jahr sicher.

Das BG Universitätsklinikum Bergmannsheil gehört zur Unternehmensgruppe der BG Kliniken. Die BG Kliniken sind spezialisiert auf die Akutversorgung und Rehabilitation schwerverletzter und berufserkrankter Menschen. In neun Akutkliniken, zwei Kliniken für Berufskrankheiten und zwei Ambulanzen versorgen über 13.000 Beschäftigte mehr als 560.000 Fälle pro Jahr. Träger der BG Kliniken sind die gewerblichen Berufsgenossenschaften und Unfallkassen. Weitere Informationen: www.bergmannsheil.de, www.bg-kliniken.de

https://www.leitmarktagentur.nrw/lw_resource/datapool/_items/item_718/pdb_ge-2-2-023.pdf

| Projektleitung:Hochschule Ruhr West, Mülheim a.d.R.Kontakt:Herr Prof. Dr. Ioannis Iossifidis Tel.: 0208 88254-806Laufzeit:01.10.2019 – 30.09.2022Aktenzeichen:GE-2-2-023 | Verbund:Ruhr-Universität Bochum; ausführende Stelle: Universitätsklinikum Knappschaftskranken- haus Bochum GmbHRuhr-Universität Bochum; ausführende Stelle: BG Universitätsklinikum Bergmannsheil gGmbHSNAP GmbH, Bochum |

Projektbeschreibung:

Beeinträchtigung der Arm- und Greiffunktionen nach verschiedenen neurologischen Erkran- kungen schränken die Teilhabe der betroffenen Patienten und Patientinnen am Berufs- und Alltagsleben stark ein und stellen eine große Herausforderung für den Rehabilitationsprozess dar. Zur Intensivierung der konventionellen Therapie und damit Verbesserung des Rehabilita- tionserfolgs ist ein hochqualitatives, eigenständiges und alltagsnahes Training notwendig. Die Schlüsselkomponente dazu ist ein biomechanisch konzipiertes, adaptives Exoskelett für die oberen Extremitäten, das in diesem Projekt entwickelt und explorativ am Patienten einge- setzt werden soll. Das Exoskelett berücksichtigt die individuellen Randbedingungen der Er- krankung und kompensiert soweit wie notwendig die Dysfunktion, die die Ausführung von notwendigen Bewegungen verhindert oder unterstützt das Rehabilitationstraining durch an- tagonistische Aktivierung. Dabei liefert das System aufgrund intelligenter sensorischer und aktuatorischer Verknüpfung immer genau so viel Unterstützung oder Korrektur, wie in der je- weiligen Patientensituation notwendig ist.

Mit dem Exoskelett wird ein ganzheitliches Rehabilitationssystem entwickelt. Das System be- inhaltet den Entwurf und die Implementierung von Bewegungsaufgaben in der virtuellen Rea- lität, ein auf Biosignalen basierendes Feedback-System sowie einen generischen Dekoder für invasive und nicht invasive Brain-Computer- Interfaces. In der technischen Umsetzung vereint das Soft- Exoskelett moderne, sehr leichte, belastbare Materialien mit einer intelligenten, adaptiven Regelung, die vom Träger bzw. der Trägerin keinerlei Einstellungen verlangen. Im Ergebnis ergeben sich neue Perspektiven für eine verbesserte Rehabilitation von Arm- und Handfunktionen. Dadurch kann die Versorgung von Patienten und Patientinnen maßgeblich verbessert werden.

Gesamtausgaben: 2.451.259,58 € Zuwendungssumme: 2.134.897,53 €

Start des Forschungsprojekts „Smarte Rehabilitation der oberen Extremitäten durch ein intelligentes Soft-Exoskelett“ (REXO). Hochschule Ruhr West übernimmt die Rolle des Konsortialführers. Projektpartner sind das Knappschaftskrankenhaus, das Klinikum Bergmannsheil und die SNAP GmbH. Beeinträchtigung der Arm- und Greiffunktionen nach Erkrankungen (z. B. Schlaganfall) schränken Patienten stark ein und stellen eine große Herausforderung für den Rehabilitationsprozess dar. Zur Intensivierung der Therapie ist ein hochqualitatives Training notwendig. Schlüsselkomponente ist ein Exoskelett für die oberen Extremitäten, das in diesem Projekt entwickelt und explorativ eingesetzt werden soll.

https://idw-online.de/en/news730101

Einen „Virtuellen Arm- und Handtest mithilfe von maschinellem Lernen bei neurologischen Bewegungsstörungen“ entwickelt die Hochschule Ruhr West (HRW) und ihre Partner im Forschungsprojekt „VAFES“. Prof. Dr. Andreas Pinkwart, Minister für Wirtschaft und Digitalisierung des Landes NRW, übergab kürzlich den Förderbescheid.

Bottrop, 15. Januar 2020: Innerhalb des Forschungsprojektes „VAFES“ entwickeln die Hochschule Ruhr West und ihre Partner einen „Virtuellen Arm- und Handtest mithilfe von maschinellem Lernen bei neurologischen Bewegungsstörungen“. Prof. Dr. Andreas Pinkwart, Minister für Wirtschaft und Digitalisierung des Landes NRW, übergab kürzlich den Förderbescheid. Am heutigen Mittwoch fand das Kick-off-Meeting der Projektpartner am HRW Campus statt.

Die Arm- und Handbewegungen von Parkinson- und Schlaganfall-Patient*innen oder Patienten mit Rückenmarksverletzungen sind oft stark eingeschränkt. Diese Einschränkungen haben enorme Auswirkungen auf die Lebensqualität der betroffenen Patient*innen. Eine differenzierte Diagnose der Hand- und Armfunktion ist sowohl zur Therapiesteuerung als auch zur Früherkennung von großer Bedeutung.

Die Wissenschaftler*innen im Projekt VAFES wollen ein standardisiertes Testsystem entwickeln und in der Virtual Reality (VR) umsetzen. Die Aufnahme multipler Biosignale – in Kombination mit präzisen Bewegungsdaten – ermöglichen erstmalig den Einsatz moderner Machine Learning (ML) Algorithmen zur Diagnose, Klassifikation und Therapiesteuerung von neurologisch bedingten Hand- und Armdysfunktionen.

Therapeutisch werden die gewonnenen Erkenntnisse zur Tremorbehandlung (rhythmisches Muskelzittern), zur Etablierung VR-gestützter Neurofeedback-Therapieansätze bei Bewegungsstörungen und zur Feinkalibrierung der Tiefenhirnstimulation bei der Parkinsonbehandlung eingesetzt. Die entwickelten modularen Hard- und Software-Komponenten werden sowohl klinisch / wissenschaftlich (VR-Testumgebung) als auch wirtschaftlich (Testinstrument, Decoder, aktiver Sensorhandschuh) verwertet.

Für ihr Vorhaben erhält die Hochschule Ruhr West mit ihren Projektpartnern für die nächsten drei Jahre eine Förderung aus Mitteln des europäischen Fonds für regionale Entwicklung (EFRE) und des Landes Nordrhein-Westfalen in Höhe von 2,36 Millionen Euro.

Das Institut Informatik der Hochschule Ruhr West übernimmt mit Prof. Dr. Ioannis Iossifidis die Rolle des Konsortialführers. Projektpartner sind das RUB Universitätsklinikum Knappschaftskrankenhaus Bochum, vertreten durch Dr. Christian Klaes, das RUB Universitätsklinikum Bergmannsheil Bochum, vertreten durch Dr. Matthias Sczesny-Kaiser, und die SNAP GmbH, vertreten durch Dr. Corinna Weber.

Der sogenannte Leitmarktwettbewerb „IKT.NRW“ fördert zahlreiche innovative Projekte aus Wirtschaft und Forschung im Bereich der Informations- und Kommunikationstechnologien.

In der finalen Runde des Wettbewerbs empfahl eine unabhängige Jury elf Projekte mit 42 beteiligten Partnern zur Förderung. Die Gesamtfördersumme aus EU- und Landesmitteln beläuft sich auf 16 Mio. Euro.

Prof. Dr. Andreas Pinkwart, Minister für Wirtschaft und Digitalisierung des Landes NRW, gratulierte zur Förderung des Projekts, ist gespannt auf die Umsetzung der Ideen und wünschte den Vorhaben viel Erfolg: „Elf herausragende Projekte gehen an den Start und zeigen, dass starke Konsortien aus Wirtschaft und Wissenschaft aktiv die Weichen für die Zukunft stellen. Informations- und Kommunikationstechnologien sind der Treiber für die digitale Transformation, insbesondere für den Standort Nordrhein-Westfalen. Das unterstreichen die geförderten Vorhaben aus den Bereichen Energie, Produktion, Mobilität, Logistik, Gesundheit oder Arbeit der Zukunft.“

Contact for scientific information:

Prof. Dr. Ioannis Iossifidis

Telefon: 0208/ 882 54 806

E-Mail: Ioannis.Iossifidis@hs-ruhrwest.de

More information:

Student project within the module “Autonomous Systems” at Ruhr West University of Applied Sciences.

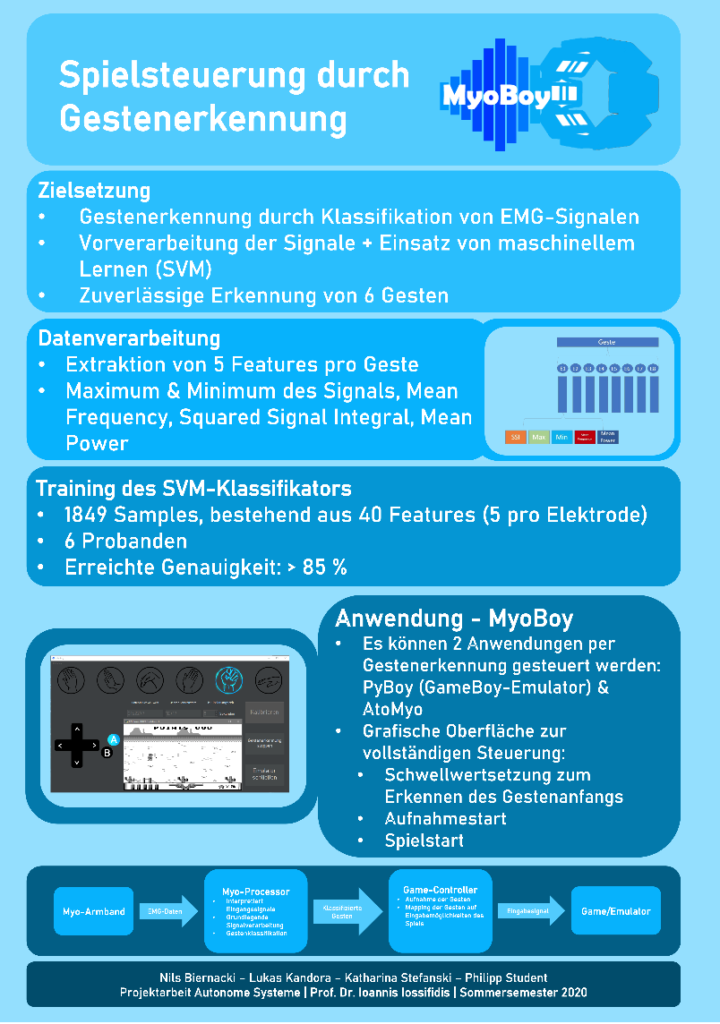

| Students | Nils Biernacki, Lukas Kandora, Katharina Stefanski, Philipp Student |

| Supervision | M.Sc. Nique Schmidt and Prof. Dr. Ioannis Iossifidis |

| Project site | https://gitlab.hs-ruhrwest.de/iSystemsStudentProjects/2020/eeg-emg-gamecontroller |

live demo

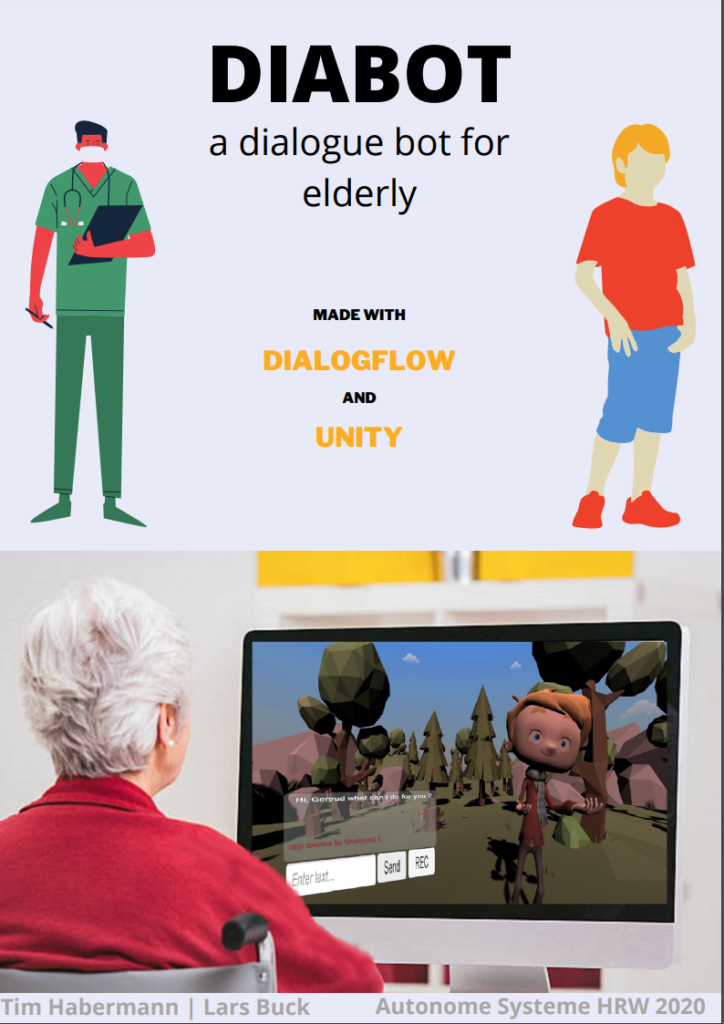

Student project within the module “Autonomous Systems” at Ruhr West University of Applied Sciences.

| Students | Lars Buck, Tim Habermann |

| Supervision | M.Sc. Stephan Lehmler, Prof. Dr. Ioannis Iossifidis |

| Project site |

The project aim to create a dialog bot with an animated avatar able to have a casual conversation and to assist the user. The dialog bot is supposed to enrich the social live especially of elders people.

live demo

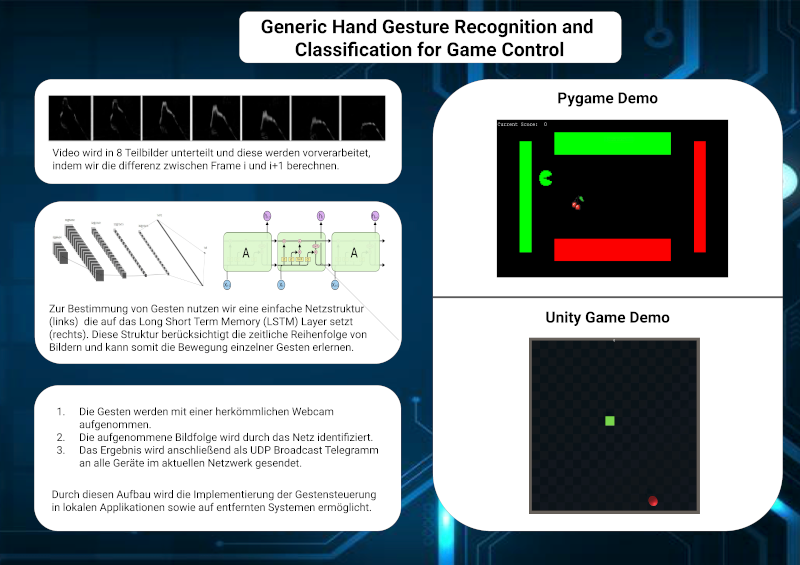

Student project within the module “Autonomous Systems” at Ruhr West University of Applied Sciences.

| Students | Merih Türkoglu, Matthias Weibrecht |

| Supervision | Prof. Dr. Ioannis Iossifidis |

| Project site | https://gitlab.hs-ruhrwest.de/iSystemsStudentProjects/2020/generic-gesture-recognition-and-classification-for-game-vr-control |

The goal of this project is to develop a gesture recognition based on common webcams and low budget hardware to implement hand gesture control in any application.

live demo

Student project within the module “Autonomous Systems” at Ruhr West University of Applied Sciences.

| Students | Alexander Klee, Mahdi El Mesoudy,Jan Dehlen |

| Supervision | M.Sc. Felix Grün and M.Sc. Stephan Lehmer |

| Prozent site | https://gitlab.hs-ruhrwest.de/iSystemsStudentProjects/2020/ml-based-stockmarket-prediction |

live demo of the command line tool

Consortium: Prof. Dr. Ioannis Iossifidis (PI, consortium lead), Dr. Christian Klaes (PI), Ruhr University Bochum-Knappschaft University Hospital, Prof. Dr. Martin Tegenthoff (PI) Ruhr University- Bergmannsheil University Hospital, Dr. Corinna Weber, Snap GmbH (PI))

- Project duration: 01/2020 — 12/2022

- Funding volume: € 2.092.917,-

Restrictions in hand and arm function are a highly relevant consequence of neurological diseases, such as Parkinson’s disease, strokes or spinal cord injuries, and have an enormous impact on the quality of life and participation of affected patients. A differentiated diagnosis of hand and arm function is of great importance both for therapy control and for early detection. At present, however, very different and only conditionally objectifiable test instruments are used for specific indications, which result in an inaccuracy retest and make it difficult to compare results. In addition, relevant biosignals such as EEG and EMG are not used or not used in direct combination with the functional tests.

In this project a standardized test environment in Virtual Reality (VR) will be developed. Motion trackers and VR gloves cover a broad spectrum of relevant motion parameters. In particular, synchronous electroencephalographic (EEG) recordings supplement the motion data with neuronal signals. This combination makes it possible for the first time to use modern Machine Learning (ML) algorithms, such as deep learning, in the context of diagnosis and therapy of neurological diseases with hand and arm dysfunctions.

The easy-to-use functional test can be used in particular for complex extrapyramidal and/or cerebellar movement disorders in order to objectively classify the movement deficits and compare them with comparative data. Due to the increased sensitivity of the test and a generative model of arm movements, different stages of the disease can be better distinguished and the course of the disease more clearly documented. The early detection of diseases with a gradual course should also be improved. Therapeutically, the insights gained in tremor treatment – here by means of a hand exoskeleton to be developed in the project – will be used to establish VR-supported neurofeedback therapy approaches for extrapyramidal and cerebellar movement disorders and for fine calibration for deep brain stimulation for Parkinson’s treatment.

Movement and correlated EEG data from both healthy volunteers and patients will be used to build a publicly accessible database. The database will be made available as a reference for the development and validation of models and methods for the scientific community and companies. The developed modular hardware and software components will be used clinically / scientifically (VR test environment) as well as economically (test instrument, decoder, hand exoskeleton).

Treffen Sie uns auf der ITSC2012 in Alaska. Wir präsentieren unsere Arbeit zur Entwicklung einer integrierten Architektur zur Entwicklung und Prüfung von Fahrerassistenzsystemen.

Abastract: Advanced Driver Assistant Systems act, by definition in natural, often poorly structured, environments and are supposed to closely interact with human operators. Both, natural environments as well as human behaviour have no inherent metric and can not be modelled/measured in the classical way physically plausibly behaving systems are described.

This makes the development of a new methodology and especially the development of an experimental environment necessary, reflecting all constraints of the task to be observed, incorporating the influence of each single component and the generation of variations over scenes and behaviours. In this contribution we focus on the development of an integrated architecture based on a simulated reality framework incorporating simple behavioural models of autonomous acting humans, physical plausible behaving scene objects, a dynamic scene generator and an advanced recording and analysing system, operating on-line on all data streams. The architecture allows to develop, asses and benchmark embedded components, as well as whole ADAS.

This makes the development of a new methodology and especially the development of an experimental environment necessary, reflecting all constraints of the task to be observed, incorporating the influence of each single component and the generation of variations over scenes and behaviours. In this contribution we focus on the development of an integrated architecture based on a simulated reality framework incorporating simple behavioural models of autonomous acting humans, physical plausible behaving scene objects, a dynamic scene generator and an advanced recording and analysing system, operating on-line on all data streams. The architecture allows to develop, asses and benchmark embedded components, as well as whole ADAS.

Meet us at the ITSC2012 in Alaska. We will present our work about an integrated architecture for the development and assessment of ADAS.

Abastract: Advanced Driver Assistant Systems act, by definition in natural, often poorly structured, environments and are supposed to closely interact with human operators. Both, natural environments as well as human behaviour have no inherent metric and can not be modelled/measured in the classical way physically plausibly behaving systems are described.

This makes the development of a new methodology and especially the development of an experimental environment necessary, reflecting all constraints of the task to be observed, incorporating the influence of each single component and the generation of variations over scenes and behaviours. In this contribution we focus on the development of an integrated architecture based on a simulated reality framework incorporating simple behavioural models of autonomous acting humans, physical plausible behaving scene objects, a dynamic scene generator and an advanced recording and analysing system, operating on-line on all data streams. The architecture allows to develop, asses and benchmark embedded components, as well as whole ADAS.

This makes the development of a new methodology and especially the development of an experimental environment necessary, reflecting all constraints of the task to be observed, incorporating the influence of each single component and the generation of variations over scenes and behaviours. In this contribution we focus on the development of an integrated architecture based on a simulated reality framework incorporating simple behavioural models of autonomous acting humans, physical plausible behaving scene objects, a dynamic scene generator and an advanced recording and analysing system, operating on-line on all data streams. The architecture allows to develop, asses and benchmark embedded components, as well as whole ADAS.

The generation of behavior for autonomous robots in complex environments is restricted by a potentially large number of constraints that must be observed. For many tasks, the relevant constraints can be expressed in a specific, low-dimensional reference frame. The dynamic systems approach to autonomous robotics represents constraints as attractors or repellors over such behaviorally relevant variables. This article presents a framework in which each constraint is treated independently as a dynamical system over a behavioral variable and provides a mechanism for the integration of these dynamical systems as contributions to a common vector field for movement generation. As a demonstration, we treat manipulation tasks for long cylindrical objects as a collection of separate constraints that are interpreted and solved with the proposed techniques. The resulting system is implemented on the small humanoid robot Nao and used to solve two exemplary movement tasks.